Huawei zaprosiło mnie do Berlina, gdzie 7 maja, w hotelu JW Marriot odbyło się wydarzenie poświęcone tematyce magazynowania, zabezpieczenia i przetwarzania danych – Huawei Innovative Data Infrastructure Forum 2024. Jakie nowości zaprezentował chiński producent?

Huawei Innovative Data Infrastructure Forum 2024 zgromadziło czołowych przedstawicieli branży ICT oraz ekspertów w dziedzinie przechowywania danych. Tegoroczna edycja, pod hasłem „Data Awakening: Building Leading AI-Ready Data Infrastructure”. Rzeczywiście, główną prezentowaną narracją Huawei w Berlinie była, słuszna skądinąd teza, że dynamiczny rozwój AI powoduje wyraźny wzrost zapotrzebowania na wydajne i efektywne technologie storage.

Spotkanie rozpoczęło się od przemówienia Wili’ego Songa, prezesa European Enterprise Business w Huawei, który wiele uwagi poświęcił rozwojowi AI i wpływowi tego trendu na inne segmenty rynku. Wskazał przy tym jak Huawei wspomaga cyfrową transformację w Europie, w tym także w obszarze centrów danych i, zgodnie z tematyką wydarzenia, systemów magazynowania danych.

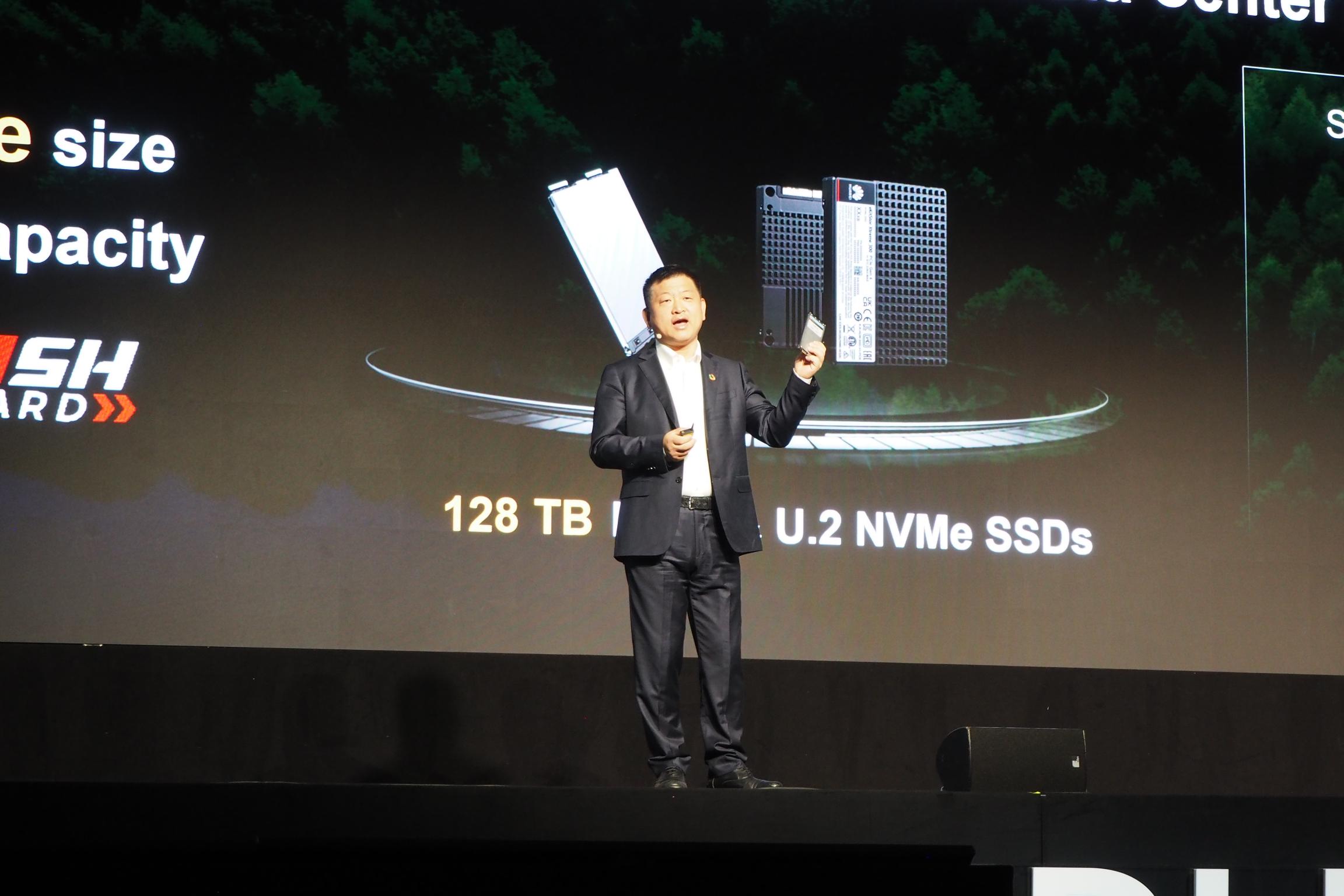

Na scenie pojawił się też dr Peter Zhou, wiceprezes Huawei i prezes linii produktów do przechowywania danych. Jego wystąpienie, znacznie bardziej produktowe, skupione było raczej na potrzebach rynku w obliczu rosnącego zapotrzebowania na przechowywanie danych generowanych przez sztuczną inteligencję. Podkreślił również wyzwania związane z ekologicznym aspektem rosnącego zużycia energii przez centra danych oraz konieczność rozwoju energooszczędnych rozwiązań w informatyce. Nie da się ukryć, że w skali świata problem zużycia energii przez centra danych jest pokaźny. Peter Zhou przyrównał prognozowane zużycie energii przez wszystkie centra danych w 2026 roku, mające wynieść około 1050 TWh, do aktualnego zapotrzebowania energetycznego… Japonii. Przyczyną jest m.in. rosnące obciążenie związane z rozwojem AI.

No dobrze, ale jak to się wiąże z systemami storage? Otóż, jak argumentował wiceprezes Huawei i prezes linii produktów do przechowywania danych, jest to związane z aktualnym paradoksem widocznym w centrach danych. Faktyczne użytkowanie klastrów pracujących nad AI jest niskie, nie osiąga nawet 50%. Dlaczego tak się dzieje? Ponieważ, stosując naprawdę szybkie GPU (to one dokonują większości obliczeń dla AI), podsystemy związane z przechowywaniem danych zwyczajnie “nie nadążają”. W efektywnym systemie nikt nie lubi pustych przebiegów i to właśnie tu swojej szansy upatruje Huawei, z nowymi, bardzo szybkimi produktami.

Następnie na scenę wchodzili także mówcy niezwiązani bezpośrednio z Huawei. Andrew Buss, Senior Research Director w IDC EMEA, opowiedział m.in. o przewagach wytwarzanych przez stosowanie AI w firmach, a także o badaniach wskazujących na coraz szersze zainteresowanie przedsiębiorstw sztuczną inteligencją. Wymienił kilka głównych trendów rynkowych na przyszłość. Jego zdaniem, kluczowym trendem jest tzw. “Digital Shift”, co oznacza odchodzenie od tradycyjnych form gospodarki na rzecz tych, w których istnieje udział sztucznej inteligencji.

Jednocześnie, jak wynika z badań IDC przedstawionych przez Andrew Bussa, realnie automatyzację wprowadzają na tę chwilę liderzy, około 25% przedsiębiorstw. Większość, ponad 50%, jest dopiero na początku swojej drogi z AI. To natomiast oznacza, że żadnego zainteresowania sztuczną inteligencją nie przejawia jedynie niewielka część firm. To jednak oznacza, że istnieje wielka szansa na zaopatrzenie dla wzrastających potrzeb rynku. Interesujące jest także to, jak wg. badań IDC sami liderzy postrzegają priorytety strategiczne. Na pierwszym miejscy wymieniają oni dbałość o bezpieczeństwo, co w obecnym środowisku wydaje się doskonale zrozumiałe i co podzielały też inne ankietowane firmy. Różnią jest jednak drugi z priorytetów: zdolność do adaptacji. Świetnym przykładem, który padł ze sceny jest transformacja Ubera w czasie pandemii, z firmy taksówkarskiej, do dostawcy dowożącego jedzenie. To było możliwe wyłącznie dzięki adaptywności napędzanej technologią. Co ciekawe, firmy spoza grupy liderów wskazywały na oszczędności budżetowe.

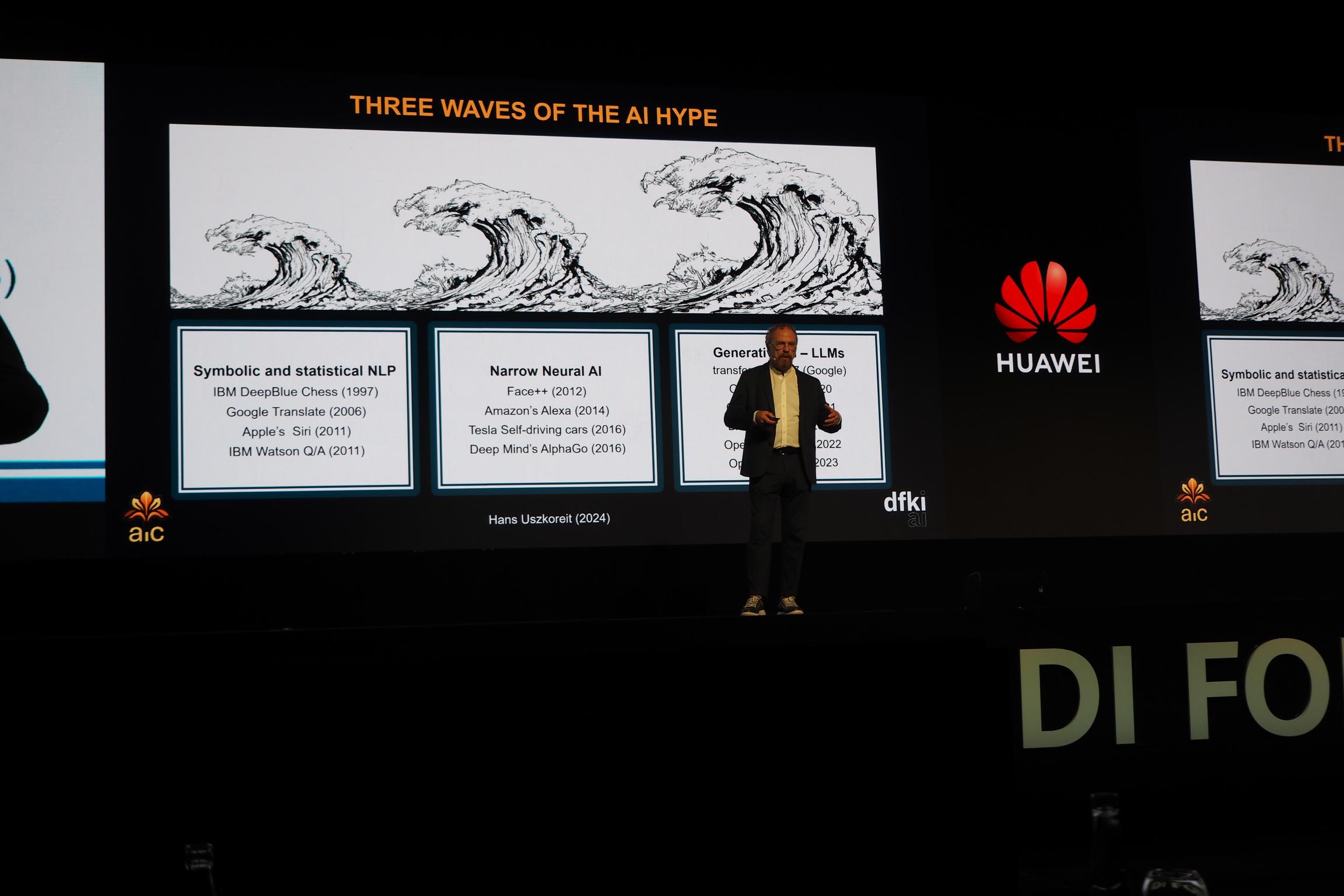

Dr. Hans Uszkoreit, dyrektor z Deutsches Forschungszentrum für Künstliche Intelligenz (DFKI) i członek European Academy of Sciences (EURASC) rozpoczął swoje wystąpienie od stwierdzenia, że obecnie obserwowany AI hype nie jest zjawiskiem nowym. Naukowiec podkreślił, że zjawisko to obserwujemy w kolejnych falach, z których pierwsza miała miejsce… jeszcze pod koniec lat 90tych. AI ponad 25 lat temu? Owszem. Dziś nie każdy to pamięta, ale to w 1997 roku IBM DeepBlue rozegrał partię szachów, w której niekwestionowany mistrz, Garri Kasparow, musiał uznać wyższość maszyny. Dalej przyszły Google Translate (2006), Apple Siri (2011) czy IBM Watson (2011). To była era modeli symbolicznych i statystycznych – stosunkowo prostych z dzisiejszego punktu widzenia. Kolejna fala niosła ze sobą tzw. wąskie modele neuralne, a więc oparte na specjalizowanych sieciach neuronowych. Ich rynkową emanacją były np. Amazon Alexa (2014) czy Deep Mind AlphaGo (2016). To, co obserwujemy dziś, to fala generatywnych AI, dużych modeli językowych (LLM). ChatGPT, DALL-E czy Gemini to właśnie produkty tej fali. Co ważne, zdaniem niemieckiego naukowca, każda kolejna fala jest wyższa, większa, a jej wpływ bardziej widoczny.

To, co zdaniem dr. Uszkoreita jest szczególnie ciekawe w obecnej fali to tzw. cross-modal models, a więc modele zdolne do pracy na więcej niż jednym typie danych. Łączą one język naturalny np. z obrazami lub video. To pozwala na nieosiągalne wcześniej możliwości. Jednocześnie, naukowiec wskazał jako największy hamulec w rozwoju AI nie, jak można by przypuszczać, algorytmy, ale infrastrukturę sprzętową. W tym obszarze mamy jeszcze wiele do zrobienia, zdaniem dr. Uszkoreita.

Narracja płynąca ze sceny była niejako potwierdzeniem zasadności wzmacniania infrastruktury sprzętowej, szczególnie w obszarze storage. Huawei na scenie w Berlinie zaprezentowało nowy model OceanStor A800, który stanowi zaawansowane rozwiązanie idealnie dopasowane do potrzeb współczesnych przedsiębiorstw, które polegają na danych. Tak się składa, że na danych, polegają dziś właściwie wszystkie firmy.

Czym jest OceanStor A800? To specjalistyczne rozwiązanie do przechowywania danych dla potrzeb sztucznej inteligencji, który stanowi część rodziny rozwiązań storage Huawei OceanStor. Jak wspomniał ze sceny dr. Peter Zhou, Huawei dąży do “zdefiniowania na nowo przechowywania danych”, inwestując w innowacje w sześciu różnych obszarach: wydajność, odporność danych, nowe paradygmaty danych, takie jak technologia generowania z uzupełnieniem wyszukiwania (RAG), skalowalność, zrównoważenie i strukturę danych, poprawę możliwości zarządzania metadanymi przechowywania. To właśnie te innowacje, według dr. Zhou, doprowadziły do opracowania A800.

To oparte na procesorach ARM rozwiązanie może skalować się na poziomie EB do maksymalnie 512 kontrolerów i 4 096 kart obliczeniowych. Zhou powiedział, że A800 jest również najbardziej energooszczędnym rozwiązaniem przechowywania firmy do tej pory, oferującą gęstość przechowywania 1PB na 1U i może zapewnić efektywność energetyczną na poziomie 0,7 W na TB. Obsługuje trzy nowe paradygmaty danych: indeks wektorowy, dane tensorowe i RAG. W konsekwencji, A800 zwiększa również wykorzystanie klastrów AI o 30 procent i zapewnia czterokrotnie większą przepustowość Gbps oraz osiem razy więcej operacji wejścia-wyjścia na sekundę (IOPS) niż równoważne rozwiązanie przechowywania innego, nienazwanego dostawcy (chociaż na prezentacji został on określony mianem “vendor D” więc nietrudno się domyślić, o kogo może chodzić).

A800 obsługuje system plików Omni-Dataverse, przestrzeń nazw i strukturę danych wbudowaną w silnik zarządzania danymi (Data Management Engine, DME). DME pomaga zarządzać danymi w celu zapewnienia dostępu do danych na żądanie, a także zabezpiecza ochronę danych. Wykorzystuje również sztuczną inteligencję, aby identyfikować potencjalne zagrożenia i zapobiegać problemom, takim jak lokalizowanie problemów z wydajnością.

Huawei OceanStore A800 wykorzystuje do składowania danych jedną inną nowość, zaprezentowaną w Berlinie. Chodzi o nośnik NAND o wyjątkowo wysokiej gęstości. Jak podał Huawei, może on zapewnić pojemność 128TB na dysk, zużywając 88 procent mniej miejsca i 92 procent mniej energii na PB danych w porównaniu z innym, nieokreślonym rozwiązaniem nośnika półprzewodnikowego innego dostawcy. Michael Fan, Huawei Data Storage marketing VP, podczas spotkania z mediami przyznał, że nośnik korzysta z dwóch rodzajów pamięci: TLC oaz QLC. Pojawi się w kilku formatach, w każdym korzystając z interfejsu U2 NVMe. NA wydarzeniu mogliśmy zobaczyć z bliska format nazwany Palm.

Dr. Peter Zhou, zapytany przeze mnie podczas spotkania z mediami o główne czynniki stymulujące rozwój sektora storage, odpowiedział:

“Dostrzegamy, że przechowywanie jest zdecydowanie kluczowym elementem, szczególnie dla procesu digitalizacji. W przeszłości cała branża starała się korzystać z usług informatycznych w celu udostępnienia zdigitalizowanych informacji. Teraz jednak proces digitalizacji staje się coraz bardziej zaawansowany, dane nie tylko prezentują informacje. Dane również przedstawiają sobą aktywa oraz wartość w dużej ilości danych. Dlatego niektórzy twierdzą, że dane są w pewien sposób odpowiednikiem tego, czym dla XX wieku była ropa naftowa. Zdecydowanie wierzymy, że dane stają się rzeczywistym aktywem przyszłości” – wyjaśnił dr. Zhou – “Istnieje kilka kierunków, o których musimy pamiętać. Po pierwsze, sztuczna inteligencja stale się rozwija. Obecnie, gdy rozmawiamy o sztucznej inteligencji, zwłaszcza o generatywnej sztucznej inteligencji, coraz więcej osób twierdzi, że brakuje nam danych jako materiału do generowania większej wartości. Kolejny kierunek to rodzaj wirtualizacji rzeczywistości, można by rzec. To także bardzo ważne dzisiaj, jeśli spojrzymy na technologie autonomicznych pojazdów, jak rozwijane są te technologie, zauważymy, że wiele osób jeździ tymi samochodami po drogach (red. tu oczywiście nie mówimy o pełnej autonomiczności, przynajmniej jeszcze nie), zbierając dane oraz przeprowadzając eksperymenty w celu testowania tych algorytmów w samochodach autonomicznych, ale już w rzeczywistym świecie. Jeśli moglibyśmy stworzyć wirtualną rzeczywistość i przeprowadzać symulacje w zdigitalizowanym świecie, to efektywność rozwoju tych nowych technologii mogłaby być dalsza poprawiona. To również wymaga dużej ilości danych. Dlatego zdecydowanie wierzymy, że przechowywanie danych będzie odgrywać coraz ważniejszą rolę w przyszłości.

Podobnie jak papier, kilkaset lat temu, od kiedy ludzie uzyskali dostęp do papieru, zaczęliśmy taniej “produkować wiedzę” i dzielić się nią. W erze digitalizacji, papierem jest przechowywanie danych, więc zdecydowanie odgrywa coraz ważniejsze role. Jesteśmy więc wytwórcą papieru dla ery cyfrowej. Ale potrzebujemy nowych technologii, przede wszystkim opłacalnego przechowywania danych. Czy możemy za tę samą cenę uzyskać większą ilość danych? Po drugie, w zakresie zrównoważonego rozwoju, czy możemy stosować zielone technologie? Obecnie w centrach danych prawie 30% energii zużywane jest przez sprzęt do magazynowania danych, co stanowi ogromną ilość. Czy możemy użyć technologii, aby drastycznie zmniejszyć zużycie energii na ten cel? W przeciwnym razie będziemy zmuszeni zużyć dużą ilość energii, a wtedy wartość digitalizacji w pewien sposób zostanie ograniczona. Uważam, że to naprawdę interesujące i ważne obszary. Dlatego musimy nadal inwestować w to, zatrudniając więcej ludzi do badań i rozwoju, więcej inżynierów, więcej współprac na całym świecie. Staramy się wprowadzać nowe technologie, innowacje co roku. Myślę, że dobrze jest zauważyć, że w ciągu ostatnich kilku lat zaczęliśmy robić dość duże postępy. Na przykład w zeszłym roku osiągnęliśmy poziom 1 terabajt na jeden wat. W tym roku próbujemy podwoić efektywność. Innymi słowy, dążymy do osiągnięcia poziomu 1 TB na 0,5 W energii. (…) Jesteśmy bardzo optymistyczni co do kolejnych kroków.”

Trudno jest nie zauważyć, że wiele uwagi podczas wydarzenia wiele uwagi poświęcono właśnie zużyciu energii przez podsystem pamięci masowej. W globalnym ujęciu to rzeczywiście pokaźne liczby, a dążenie Huawei do redukcji zużycia prądu jest bez wątpienia godne pochwały. Podczas wydarzenia w Berlinie miałem wrażenie, że Huawei wraca do pryncypiów ekologicznych, nieco zapomnianych czy raczej przykrytych przez inne tematy, jak pandemia, wojna czy AI. Przyznaję, że ekologia “sprzedawana” na konkretnych liczbach, a nie jedynie na deklaracjach, jest czymś, co nie tylko brzmi dobrze, ale może też stanowić pewnego rodzaju cząstkowe rozwiązanie dla wielu krajów, w tym Polski, gdzie istnieje kroczący problem związany z energetyką. To jednak temat na zupełnie inny artykuł.

Podsumowując, widać, że obszar storage jest dla Huawei niezwykle istotny, nie tylko sprzedażowo, ale też w kontekście badań nad rozwojem technologicznym. Chiński gigant IT konsekwentnie od lat rozwija swoje portfolio dla centrów danych i dziś jest jednym z wyżej ocenianych w tym obszarze. Miliony przeznaczone na badania najwyraźniej procentują.